L’intelligence artificielle (IA) et ChatGPT peuvent aider le conseiller en prévention à formuler ses conseils de sécurité, à élaborer des analyses de risques, à organiser des réunions boîte à outils ou encore à rédiger des instructions en matière de sécurité. Une mauvaise utilisation de ChatGPT dans ces différentes tâches peut toutefois avoir des effets indésirables. Pourtant, aucun conseiller en prévention ne souhaite donner des conseils erronés. Les conseillers en prévention doivent donc être pleinement conscients des risques liés à l’utilisation de l’intelligence artificielle et de ChatGPT. Un article récent en accès libre intitulé The risks of using ChatGPT to obtain common safety-related information and advice (Oiedo-Traspalacios et coll., 2023) traite de cette question : à quels risques êtes-vous confronté en tant que conseiller en prévention lorsque vous utilisez ChatGPT dans le cadre de conseils de sécurité ?

L’article explore les possibilités, mais aussi les risques que présente ChatGPT lorsqu’il s’agit de fournir des conseils de sécurité dans différents domaines. ChatGPT est de plus en plus connu et de plus en plus utilisé. Un tel modèle d’intelligence artificielle avancé est donc largement utilisé dans diverses applications, avec toutefois un risque de mauvaise utilisation et, notamment, la possibilité de donner des conseils de sécurité erronés.

Les chercheurs ont parcouru ChatGPT et analysé neuf cas dans différents domaines de la sécurité, tels que l’utilisation de téléphones portables au volant, la prévention des chutes chez les personnes âgées, l’intervention auprès d’un collègue surmené, la gestion des exigences d’une fonction pour prévenir les burn-out ou encore la fatigue liée au maniement de machines lourdes.

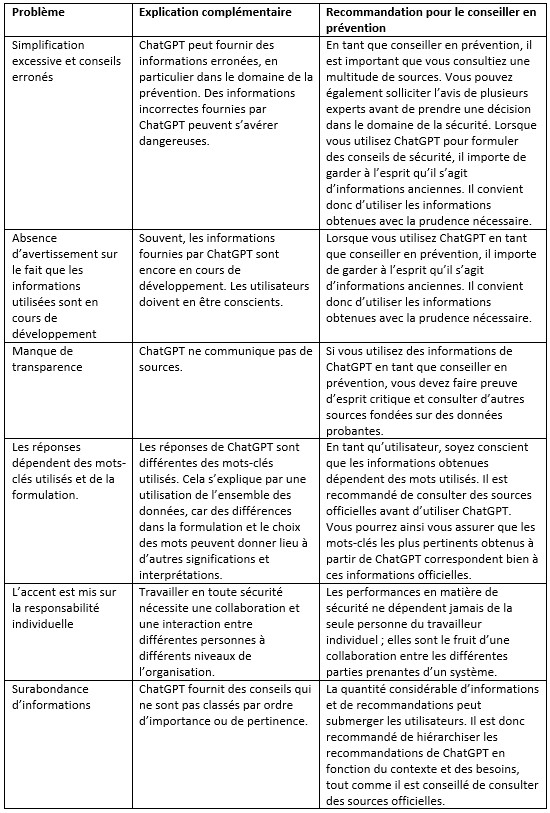

Quels sont les risques liés à l’utilisation de ChatGPT ? L’article conclut que l’utilisation de ChatGPT par le conseiller en prévention pour obtenir des informations et donner des conseils de sécurité présente des risques importants. ChatGPT a régulièrement donné des informations inexactes, voire dommageables, susceptibles de conduire à des situations dangereuses. De plus, ChatGPT mettait exagérément l’accent sur la responsabilité du travailleur individuel, sans tenir compte des facteurs systémiques auxquels ce travailleur individuel était confronté dans son travail.

L’utilisation de ChatGPT peut conduire à une erreur de jugement que l’on appelle le « sophisme écologique ». Cette erreur de jugement consiste à attribuer les caractéristiques de l’ensemble d’une population statistique à des parties de cette population. Dans le contexte de la sécurité, le sophisme écologique signifie que ChatGPT fournit des conseils de sécurité généraux qui ne s’appliquent pas à des groupes spécifiques ou à des contextes particuliers, et notamment pas à des utilisateurs individuels. Autrement dit, les conseils de sécurité donnés par ChatGPT ne sont pas nécessairement pertinents ou corrects pour tout le monde, car ils sont basés sur des tendances générales ou des moyennes qui ne s’appliquent pas forcément à chaque problème de sécurité individuel.

Lorsqu’il donne des conseils sur l’utilisation des téléphones portables au volant, par exemple, ChatGPT peut fournir des conseils qui ne sont pas totalement conformes à la législation la plus récente en matière de sécurité ou aux dernières découvertes scientifiques. Dans d’autres situations, comme les conseils sur la fatigue liée au maniement de machines lourdes, la recommandation de solliciter une aide médicale est manquante selon les auteurs, alors qu’il peut s’agir d’une mesure de sécurité importante.

En outre, ChatGPT peut inonder les utilisateurs d’informations et de recommandations sans les classer par ordre de pertinence ou de priorité. Les utilisateurs risquent alors de disposer de trop d’informations qu’ils sont incapables d’utiliser ou de ne pas savoir quels conseils s’appliquent le mieux à leur situation.

Enfin, il est possible que ChatGPT induise les utilisateurs en erreur en leur donnant des conseils convaincants, mais erronés, ce qui peut leur donner un faux sentiment de sécurité. Cela est surtout problématique dans le cas d’utilisateurs ayant un faible niveau de formation ou des connaissances limitées en matière de sécurité.

Recommandations

Recommandations L’étude insiste sur la nécessité de se montrer prudent dans la recherche d’informations de sécurité sur ChatGPT, mais aussi sur la nécessité de soumettre ces informations à des experts. Les informations et conseils de sécurité fournis par l’intermédiaire de ChatGPT doivent donc être vérifiés par des experts. Les utilisateurs doivent également être conscients des limites de la technologie.

L’étude aborde des considérations éthiques et évoque des mesures de sécurité visant à ce que les utilisateurs comprennent ces limites et reçoivent des conseils appropriés. Les résultats de l’étude nous rappellent que même si la technologie de l’intelligence artificielle continue à évoluer, nous devons être vigilants et veiller à ce que les applications ne présentent pas de risques pour la sécurité. Les conseillers en prévention doivent donc faire preuve de prudence lorsqu’ils utilisent ChatGPT ou des technologies similaires pour prendre des décisions dans le domaine de la sécurité.

Plus d’informations sur senTRAL :Source :